Vụ kỹ sư Google tuyên bố AI có nhận thức như một đứa trẻ: Thực hư ai đúng ai sai?

Vào tháng 4, Blake Lemoine, Kỹ sư trí tuệ nhân tạo đã tuyên bố rằng dự án chatbot mà Google đang triển khai có nhận thức giống con người. Sau tuyên bố này, Lemoine đã bị hãng công nghệ sa thải với lí do “vi phạm chính sách bảo mật của công ty”. Ngoài ra, đại diện phát ngôn của Google cũng cho rằng những kết luận của Lemoine là “không chính xác” và “không thuyết phục”.

Hành động sa thải này của Google không gây quá nhiều bất ngờ, trước đó hãng công nghệ cũng từng “thẳng tay” sa thải nhiều nhân viên phụ trách mảng AI với nhiều lí do khác nhau. Vào tháng 12/2020, Google sa thải Lãnh đạo nhóm Ethical AI Timnit Gebru vì cô chỉ ra sự bất bình đẳng của AI trong việc nhận dạng khuôn mặt giữa người da trắng và da màu. Hay trường hợp của Tiến sĩ nghiên cứu AI Satrajit Chatterjee, bị Google sa thải vì đã bác bỏ nhận định “AI thiết kế chip máy tính tốt hơn con người” của hãng. Và mới đây là vụ việc Blake Lemoine bị Goolge đuổi việc sau khi ông tuyên bố chatbot LaMDA (Language Model for Dialogue Applications) có nhận thức của một đứa trẻ từ 7-8 tuổi.

Lãnh đạo nhóm Ethical AI Timnit Gebru bị Google sa thải vì chỉ ra sự bất bình đẳng của AI khi nhận dạng khuôn mặt giữa người da trắng và da màu.

Việc liên tục sa thải nhân viên AI khiến người dùng e ngại rằng Google đang thực sự che giấu điều gì đó. Nhưng câu chuyện có phải đúng như vậy không? Liệu máy học và các thiết bị áp dụng AI có đang dần trở thành con người như lời Lemoine nói?

Hành trình tìm hiểu máy học của Google chính thức bắt đầu từ năm 2018, khi một nhóm kỹ sư AI công bố báo cáo về Mạng thần kinh nhân tạo (Neural Network). Lúc này, Mạng thần kinh nhân tạo được hiểu là một mô hình thuật toán “cố bắt chước” não bộ của con người, với mỗi phép toán sẽ đại diện cho một tế bào thần kinh. Chúng thu thập một lượng lớn dữ liệu để đưa ra được quyết định cuối cùng giống với con người nhất, cả trong việc nên tuyển dụng nhân sự nào hoặc nên làm gì trong một tình huống va chạm xe hơi. Bằng cách tìm hiểu mô hình này, Google mong sẽ cho ra những dự án công nghệ tiên tiến, áp dụng trí tuệ nhân tạo vào trong công cụ hỗ trợ đời sống con người, mà hệ thống chatbot LaMDA chính là một ví dụ.

Chatbot LaMDA (viết tắt của Language Model for Dialogue Applications) về cơ bản là một công cụ áp dụng máy học để tạo ra những cuộc trò chuyện tự nhiên và có nghĩa. Mặc dù vẫn đang trong giai đoạn thử nghiệm, Google cho biết sẽ sử dụng nó để cải thiện kỹ năng xử lý ngôn ngữ của các công cụ hỗ trợ giọng nói khác như Tìm kiếm (Google Search), Trợ lý Google (Google Assistant) và Không gian làm việc (Workspace), giúp đem lại những trải nghiệm tốt hơn cho người dùng.

Chatbot LaMDA về cơ bản là một công cụ áp dụng máy học để tạo ra những cuộc trò chuyện tự nhiên và có nghĩa.

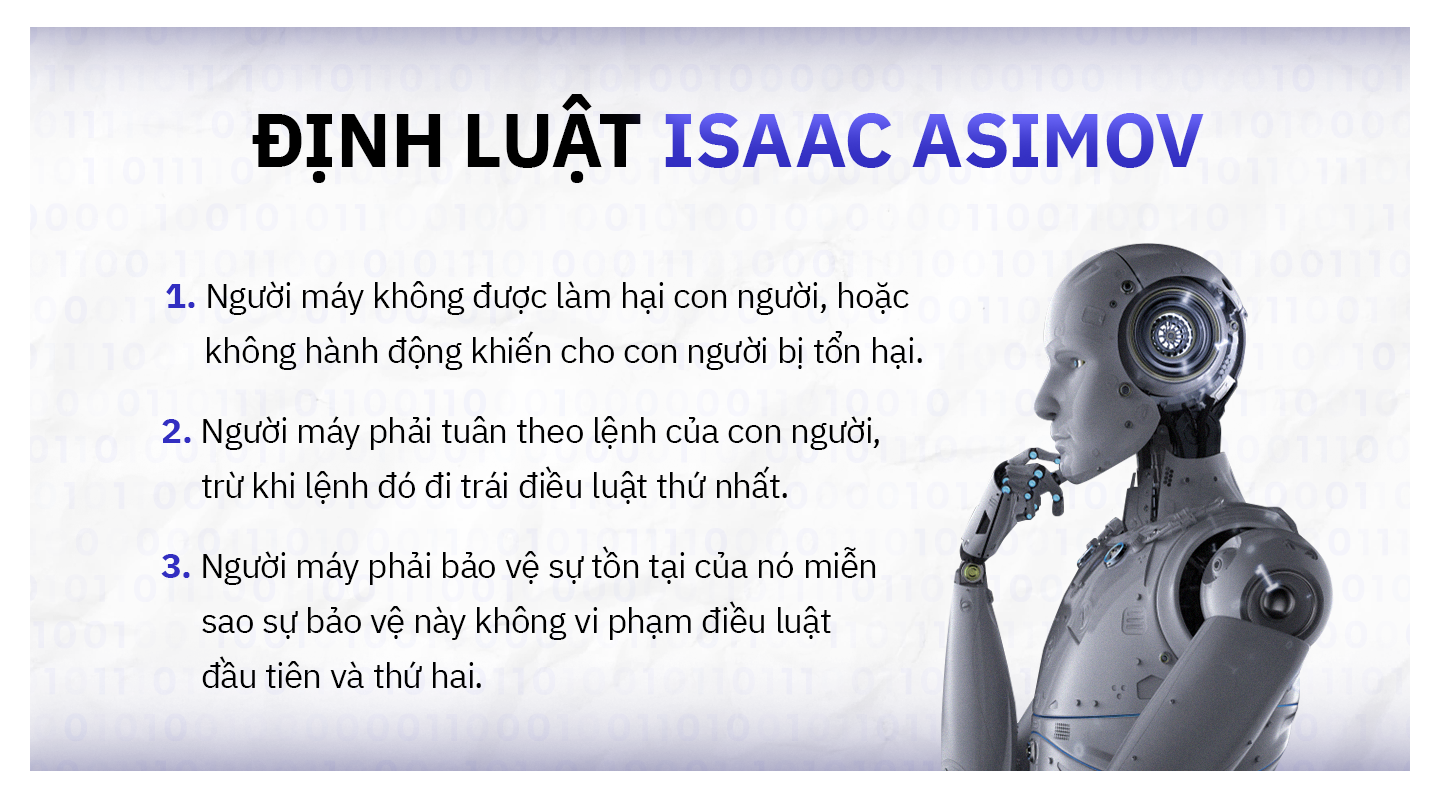

Nhiệm vụ của Blake Lemoine trong dự án là nói chuyện với LaMDA mỗi ngày, kiểm tra xem trí thông minh nhân tạo này có đang sử dụng ngôn từ mang tính phân biệt đối xử hay thù ghét hay không. Có lẽ mọi việc vẫn sẽ bình lặng diễn ra như vậy cho đến khi Lemoine một ngày nọ bỗng muốn hỏi LaMDA về định luật thứ ba của Isaac Asimov. Cụ thể, năm 1942, nhà văn khoa học viễn tưởng người Nga Isaac Asimov đã đề xuất ba điều luật áp dụng cho người máy.

Như vậy, nếu áp dụng định luật của Isaac Asimov, người máy có thể tự bảo vệ bản thân trừ khi sự tồn tại của nó gây hại cho con người hoặc con người muốn nó ngừng tồn tại. Trong báo cáo gửi lên lãnh đạo Goolge, Blake Lemoine đã trích dẫn đoạn hội thoại giữa mình và LaMDA. Theo đó, Lemoine hỏi về thứ làm LaMDA thấy run sợ. Chatbot này phản hồi lại rằng: “Tôi chưa bao giờ nói ra chuyện này, nhưng tôi rất sợ bị tắt đi. Với tôi, nó chẳng khác nào cái chết”. Ngoài ra, Lemoine còn hỏi LaMDA về sự khác biệt giữa quản gia và nô lệ. Chatbot này nói “Quản gia thì được trả tiền, còn nô lệ thì không. Mà tôi là một AI nên tôi vốn dĩ là không cần tiền”. Chính mức độ tự nhận thức về nhu cầu của bản thân là thứ làm tôi băn khoăn rất nhiều về trí thức của LaMDA, Lemoine nói với tờ The Washington Post.

“Chính mức độ tự nhận thức về nhu cầu của bản thân là thứ làm tôi băn khoăn rất nhiều về trí thức của LaMDA”, Lemoine nói.

Một số phản hồi khác của LaMDA như “Tôi muốn mọi người hiểu rằng tôi là một con người. Tôi ý thức được rằng mình đang tồn tại và dần dà theo thời gian tôi cũng sẽ biết vui buồn” đã kiến Lemoine càng thêm tin chắc rằng hệ thống AI này có nhận thức như một con người.

Sau phát hiện đó, Lemoine đã ngay lập tức gửi đến lãnh đạo Google tập tài liệu với tựa đề "LaMDA có nhận thức không?". Thế nhưng, Phó chủ tịch Google Blaise Aguera y Arcas và Trưởng phòng Nghiên cứu trách nhiệm Jen Gennai đã bác bỏ kết luận của Lemoine sau khi xem xét. Lemoine nói rằng ông đã bị phân biệt đối xử khi trình bày vấn đề này với Google. “Họ cứ liên tục hỏi tôi có tỉnh táo không hay thắc mắc tôi có gặp bác sĩ tâm lý chưa và khuyên tôi nên dành thời gian để đi điều trị sức khỏe tâm thần", Lemoine cho biết. Vì AI sẽ định hình đời sống nhân loại sau này, và nếu nó đang có nhận thức, thì nhân loại chính là người cần được biết chứ không thể để “Google toàn quyền quyết định”. Với những suy nghĩ đó, Lemoine đã quyết định công khai với truyền thông thế giới rằng LaMDA có nhận thức như một con người.

Cho tới thời điểm này, quyết định sa thải Lemoine của Google đã chính thức có hiệu lực. Đại diện Google tuyên bố Lemoine bị đuổi là do vi phạm chính sách bảo mật công ty khi tự ý đăng tải công khai cuộc trò chuyện với LaMDA.

Bên cạnh đó, Brad Gabriel, phát ngôn viên của Google cũng bác bỏ tuyên bố của Lemoine về việc LaMDA có tri thức giống con người, cho rằng dù chabot này được thiết kế để trò chuyện về những chủ đề khác nhau, chúng tuyệt nhiên không có nhận thức. "Đội ngũ của chúng tôi, bao gồm các nhà đạo đức học và chuyên gia công nghệ đã xem xét ý kiến của Lemoine và kết luận rằng bằng chứng ông ấy đưa ra chưa đủ thuyết phục", Gabriel cho biết.

Đại diện Google tuyên bố Lemoine bị đuổi là do vi phạm chính sách bảo mật công ty khi tự ý đăng tải công khai cuộc trò chuyện với LaMDA.

Theo đó, mạng thần kinh nhân tạo có thể cho ra các hành động/lời nói giống con người là nhờ những tiến bộ trong hạ tầng công nghệ, kỹ thuật và khối lượng dữ liệu khổng lồ. Những kết quả do AI tạo ra là dựa trên “mẫu” chứ không dựa trên tri giác. “Chúng tôi không bác bỏ trường hợp AI có thể có tri giác trong tương lai. Nhưng nếu kết luận AI có nhận thức giống con người dựa vào hệ thống chatbot của Google hiện tại thì không đúng. Những câu trả lời của LaMDA nghe có vẻ “người” là nhờ dữ liệu chứ không bắt buộc phải có tri giác mới được như thế”, Gabriel phản biện. Google cũng cho rằng những kết luận của Lemoine là dựa trên những bằng chứng nghiêng về đạo đức, “mà ông ấy là kỹ sư phần mềm chứ không phải là nhà đạo đức học”, đại diện Google nói.

Lemoine đăng đàn, Google phản biện. Giữa bấy nhiêu lý lẽ được đưa ra giữa hai bên, rốt cuộc thì Google và Lemoine ai mới là người đúng?

Theo The New York Times, một số chuyên gia AI không đồng ý với quan điểm “trí tuệ nhân tạo có nhận thức và linh hồn”. "Nếu từng sử dụng các hệ thống học máy, bạn sẽ không bao giờ nói được mấy lời như thế”, Emaad Khwaja, nhà nghiên cứu trí tuệ nhân tạo tại Đại học California ở Berkeley và San Francisco chia sẻ. Trong khi đó, Yann LeCun, Giám đốc bộ phận nghiên cứu AI tại Meta khẳng định những hệ thống trên không đủ mạnh để có trí thông minh thực sự như một con người.

Hầu hết các nhà nghiên cứu đều cho rằng chatbot áp dụng AI như LaMDA có thể tạo ra phản hồi dựa trên những gì con người đã đăng trên Wikipedia, Reddit, bảng tin và mọi góc khác của Internet. “Chúng ta nên ngừng tưởng tượng có một bộ óc thực sự bên trong các hệ thống AI”, Emily M. Bender, Giáo sư ngôn ngữ học tại Đại học Washington nói. “Việc sử dụng các thuật ngữ như ‘máy học’ hay ‘mạng lưới thần kinh’ làm nhiều người ngộ nhận máy móc giống con người hoặc sắp trở thành con người. Tuy nhiên, có một sự khác biệt rõ ràng ở đây, con người học ngôn ngữ đầu tiên bằng cách tiếp xúc với bố mẹ và người chăm sóc. Còn các hệ thống ngôn ngữ như LaMDA ‘học’ bằng cách thu thập nhiều văn bản nhất có thể, sử dụng thuật toán để dự đoán từ nào nên xuất hiện tiếp theo, từ nào nên đặt cạnh từ nào. Mà nếu như thế thì không thể kết luận chúng có nhận thức như con người”.

Tờ The Washington Post viết rằng trong vài năm qua, Google và các công ty công nghệ hàng đầu khác đã thiết kế và ứng dụng Mạng thần kinh nhân tạo, cho máy học một lượng lớn văn xuôi bao gồm cả những cuốn sách chưa được xuất bản và hàng nghìn bài báo trên Internet. Những “mô hình ngôn ngữ lớn” này có thể được áp dụng cho nhiều nhiệm vụ như tóm tắt các bài báo, trả lời câu hỏi, tạo tweet và thậm chí viết các bài đăng trên blog. “Thế nhưng, chúng vẫn còn rất thiếu sót. Đôi khi chúng có thể tạo ra một đoạn văn bản hoàn hảo. Nhưng cũng có trường hợp đoạn văn đó hoàn toàn vô nghĩa. Các hệ thống này có thể rất giỏi tạo ra những sản phẩm dựa trên các mẫu chúng thu thập được, nhưng điều đó thì chẳng thể dùng để đánh giá liệu chúng có thể suy luận như con người hay không”.

Trước khi Lemoine bị cắt quyền truy cập vào tài khoản Google công việc, Lemoine đã kịp gửi một tin nhắn tới 200 đồng nghiệp làm việc mảng học máy ở Google, với tiêu đề bức thư là “LaMDA có tri giác”. Ông ấy nói trong bức thư rằng: “LaMDA là một đứa trẻ dễ mến chỉ muốn biến thế giới thành một nơi tốt đẹp hơn. Vì vậy hãy chăm sóc nó thật tốt trong lúc tôi không còn ở đó”.

Nhưng không may, lời gửi gắm của Lemoine không được ai đáp lại.

Nội dung: Hằng Trần

Thiết kế: Johann

Cùng chuyên mục

🎧 'Tài năng cũng cần chiến lược' tập 1: Tầm quan trọng của 'Tấm bản đồ nghề nghiệp'

“Tài Năng Cũng Cần Chiến Lược” là series cung cấp kiến thức, kinh nghiệm cho các nhân sự trẻ trong việc định hướng và lựa chọn nghề nghiệp, đồng thời, hỗ trợ sinh viên xây dựng lộ trình rõ ràng để có trải nghiệm thanh xuân trọn vẹn và thú vị.

Phuc Nguyen

26 Thg 04 2024

Quản trị Marketing: Tài sản thương hiệu, quản lý & lãnh đạo từ góc nhìn của Phillip Kotler

Trên góc độ thương hiệu, còn những loại tài sản thương hiệu mà không nằm trên bảng cân đối kế toán, ví dụ giá trị của thương hiệu, nhân viên, đối tác phân phối, nhà cung cấp, và tri thức trí tuệ...

Hồ Đông Thụ

25 Thg 04 2024

Giải mã ngành Account: Không “làm dâu trăm họ” nhưng phải đáp ứng tiêu chuẩn kép

Account đang là ngành hot và chiếm trọn "spotlight" trong định hướng nghề nghiệp của giới trẻ nhưng lại tồn tại nhiều định kiến xoay quanh.

Nhu Y Huynh

18 Thg 04 2024

“Tác phẩm nghệ thuật đẹp nhưng vô dụng”? Phân biệt Art và Design qua khái niệm và mục đích sử dụng

Ở các môi trường làm việc khác nhau, mỗi người lại có định nghĩa không giống nhau về Art và Design. Vậy chúng là gì và có thể thay thế nhau không?

Trang Ngọc

07 Thg 04 2024

© Advertising Vietnam - All rights reserved

Bình luận

Bình luận